Desde o início do século 20, cientistas e físicos têm sido sobrecarregados em explicar como e por que o Universo parece estar se expandindo a um ritmo acelerado. Além de ser responsável pela aceleração cósmica, acredita-se que essa energia compreenda 68,3% da massa não visível do universo.

Assim como a matéria escura, a existência dessa força invisível é baseada em fenômenos observáveis e porque se encaixa nos nossos modelos atuais de cosmologia, e não em evidências diretas. Em vez disso, os cientistas devem confiar em observações indiretas, observando com que rapidez os objetos cósmicos (especificamente as supernovas do tipo Ia) se afastam de nós à medida que o universo se expande.

Esse processo seria extremamente tedioso para os cientistas - como aqueles que trabalham para o Dark Energy Survey (DES) - se não fosse pelos novos algoritmos desenvolvidos em colaboração pelos pesquisadores do Lawrence Berkeley National Laboratory e da UC Berkeley.

"Nosso algoritmo pode classificar a detecção de um candidato a supernova em cerca de 0,01 segundo, enquanto um scanner humano experiente pode levar vários segundos", disse Danny Goldstein, estudante de pós-graduação da UC Berkeley que desenvolveu o código para automatizar o processo de descoberta de supernova em imagens DES. .

Atualmente em sua segunda temporada, o DES tira fotos noturnas do céu do sul com o DECam - uma câmera de 570 megapixels montada no telescópio Victor M. Blanco no Observatório Interamericano Cerro Tololo (CTIO) nos Andes chilenos. Todas as noites, a câmera gera entre 100 Gigabytes (GB) e 1 Terabyte (TB) de dados de imagem, que são enviados ao Centro Nacional de Aplicações de Supercomputação (NCSA) e ao Fermilab do DOE em Illinois para processamento e arquivamento iniciais.

Os programas de reconhecimento de objetos desenvolvidos no NERSC (Centro Nacional de Computação Científica em Pesquisa Energética) e implementados no NCSA então vasculham as imagens em busca de possíveis detecções de supernovas do Tipo Ia. Essas explosões poderosas ocorrem em sistemas estelares binários, onde uma estrela é uma anã branca, que acumula material de uma estrela companheira até atingir uma massa crítica e explodir em uma supernova do tipo Ia.

"Essas explosões são notáveis porque podem ser usadas como indicadores de distância cósmica com precisão de 3 a 10%", diz Goldstein.

A distância é importante porque quanto mais distante um objeto está localizado no espaço, mais distante ele fica no tempo. Ao rastrear supernovas do tipo Ia a diferentes distâncias, os pesquisadores podem medir a expansão cósmica ao longo da história do universo. Isso lhes permite impor restrições à rapidez com que o universo está se expandindo e talvez até fornecer outras pistas sobre a natureza da energia escura.

"Cientificamente, é um momento realmente emocionante, porque vários grupos ao redor do mundo estão tentando medir com precisão as supernovas tipo Ia, a fim de restringir e entender a energia escura que está impulsionando a expansão acelerada do universo", diz Goldstein, que também é estudante pesquisador no Centro de Cosmologia Computacional do Berkeley Lab (C3).

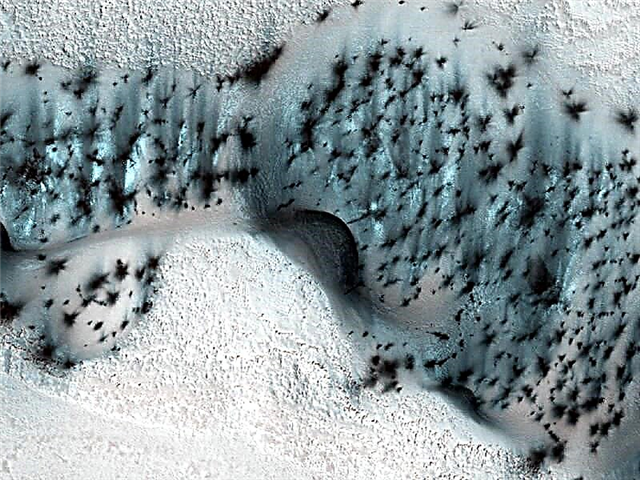

O DES inicia sua busca por explosões do Tipo Ia, descobrindo mudanças no céu noturno, onde o pipeline de subtração de imagens desenvolvido e implementado por pesquisadores do grupo de trabalho da supernova do DES entra. O pipeline subtrai imagens que contêm objetos cósmicos conhecidos de novas imagens expostas todas as noites no CTIO.

A cada noite, o gasoduto produz entre 10.000 e algumas centenas de milhares de detecções de candidatos a supernovas que precisam ser validados.

“Historicamente, astrônomos treinados ficavam sentados no computador por horas, olhavam para esses pontos e ofereciam opiniões sobre se tinham as características de uma supernova ou se foram causados por efeitos espúrios que se disfarçam de supernovas nos dados. Esse processo parece simples até você perceber que o número de candidatos que precisam ser classificados a cada noite é proibitivamente grande e apenas um em algumas centenas é uma supernova real de qualquer tipo ”, diz Goldstein. “Esse processo é extremamente tedioso e demorado. Também coloca muita pressão no grupo de trabalho de supernovas para processar e digitalizar dados rapidamente, o que é um trabalho árduo. ”

Para simplificar a tarefa de verificar os candidatos, Goldstein desenvolveu um código que usa a técnica de aprendizado de máquina “Floresta Aleatória” para verificar as detecções de candidatos a supernovas automaticamente e em tempo real para otimizá-los para o DES. A técnica emprega um conjunto de árvores de decisão para fazer automaticamente os tipos de perguntas que os astrônomos normalmente considerariam ao classificar os candidatos à supernova.

No final do processo, cada detecção de um candidato recebe uma pontuação com base na fração das árvores de decisão que o consideram ter as características de detecção de uma supernova. Quanto mais próxima a classificação estiver de uma, mais forte será o candidato. Goldstein observa que, em testes preliminares, o pipeline de classificação alcançou 96% de precisão geral.

"Quando você faz uma subtração sozinha, obtém muitos" falsos positivos "- artefatos instrumentais ou de software que aparecem como possíveis candidatos a supernovas - para que os humanos possam filtrar", diz Rollin Thomas, do C3 do Berkeley Lab, que era colaborador de Goldstein.

Ele observa que, com o classificador, os pesquisadores podem extrair com rapidez e precisão os artefatos dos candidatos à supernova. "Isso significa que, em vez de ter 20 cientistas do grupo de trabalho de supernovas continuamente filtrando milhares de candidatos todas as noites, você pode simplesmente nomear uma pessoa para ver talvez algumas centenas de candidatos fortes", diz Thomas. "Isso acelera significativamente nosso fluxo de trabalho e nos permite identificar supernovas em tempo real, o que é crucial para a realização de observações de acompanhamento".

"Usando cerca de 60 núcleos em um supercomputador, podemos classificar 200.000 detecções em cerca de 20 minutos, incluindo tempo para interação com o banco de dados e extração de recursos". diz Goldstein.

Goldstein e Thomas observam que o próximo passo neste trabalho é adicionar um segundo nível de aprendizado de máquina ao pipeline para melhorar a precisão da classificação. Essa camada extra levaria em conta como o objeto foi classificado em observações anteriores, pois determina a probabilidade de o candidato ser "real". Os pesquisadores e seus colegas estão atualmente trabalhando em diferentes abordagens para alcançar essa capacidade.